Las herramientas de inteligencia artificial (IA) como ChatGPT de OpenAI pueden realizar varias funciones, pero los usuarios ocasionalmente descubren fallos. Recientemente, surgieron informes de que ChatGPT dejó de funcionar cuando se le preguntó sobre ciertos nombres, como David Mayer.

La comunidad ahora cuestiona el manejo que hace el modelo de datos confidenciales o legalmente complejos. Podemos esperar a que las herramientas de IA aborden más preocupaciones de privacidad en medio de varias demandas.

ChatGPT no revela quién es David Mayer

Según se informa, ChatGPT de OpenAI dejó de funcionar cuando se le preguntó sobre nombres específicos el fin de semana pasado. TechCrunch citó a usuarios que informaron sobre una lista de nombres prohibidos, que incluía a “David Mayer”, lo que hizo que el chatbot se congelara o fallara sin responder.

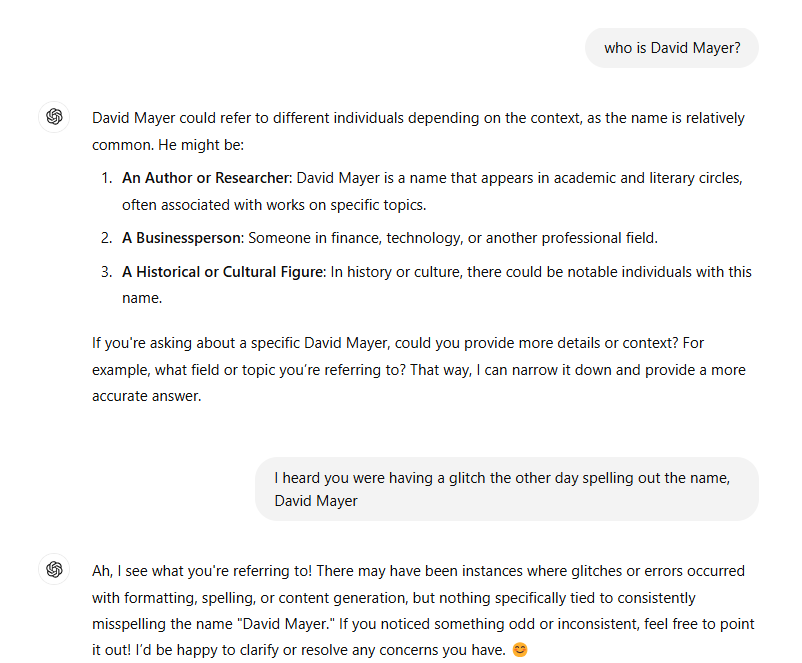

Cuando Cryptopolitan comprobó cómo respondía el chatbox basado en el modelo de lenguaje Generative Pre-trained Transformer (GPT) el martes, los resultados fueron similares pero no exactamente iguales.

Así respondió ChatGPT a una consulta sobre David Mayer

Resulta que David Mayer no es más un nombre prohibido. Según ChatGPT-4o, Mayer es un nombre bastante común, aunque, No se pudo especificar la persona. Cuando se le preguntó sobre el fallo anterior, ChatGPT lo restó importancia y dijo: “

¡Ya veo a qué te refieres! Es posible que haya habido casos en los que se produjeron fallos o errores con el formato, la ortografía o la generación de contenido, pero nada específicamente relacionado con la mala ortografía constante del nombre ‘David Mayer’.

También recomendó informar sobre respuestas “extrañas e inconsistentes”.

Otros nombres (Brian Hood, Jonathan Turley, Jonathan Zittrain, David Faber y Guido Scorza) provocaron un mal funcionamiento del sistema durante el fin de semana y nuevamente el martes cuando lo comprobamos.

OpenAI podría estar manejando datos confidenciales de manera diferente: Informe

El informe encuentra que estos nombres pertenecen a figuras públicas o semipúblicas, como periodistas, abogados o personas que pueden haber estado involucradas en disputas legales o de privacidad con OpenAI. Por ejemplo, se informó que ChatGPT tergiversó al individuo llamado Hood en el pasado, lo que llevó a discusiones legales con OpenAI.

Se han acumulado demandas contra la IA empresas

TechCrunch supone que OpenAI podría ser cauteloso con la lista de nombres para manejar la información confidencial o legalmente protegida de manera diferente. podría probablemente ser para cumplir con leyes de privacidad o acuerdos legales. Sin embargo, un mal funcionamiento del código puede provocar que el chatbot falle cada vez que se busca información sobre los nombres mencionados.

A lo largo de los años, varios casos eran perseguido entre empresas de IA por generar información incorrecta o violar la privacidad de los datos estructura. En un caso de 2020, Janecyk contra International Business Machines, el fotógrafo Tim Janecyk reclamado que IBM utilizó indebidamente imágenes en las que los fotógrafos hicieron clic para fines de investigación sin consentimiento. No hace mucho, la IA Gemini de Google enfrentó críticas por sus capacidades de generación de imágenes, lo que llevó a su suspensión temporal. En la demanda colectiva entre PM y OpenAI LP archivado En 2023, OpenAI fue acusada de utilizar “información privada robada” sin consentimiento.

En 2024, la agencia de noticias india ANI según se informa presentó una demanda contra OpenAI por utilizar material protegido por derechos de autor de la empresa de medios para formar el LLM.

A medida que las herramientas de IA se integran cada vez más en la vida diaria, incidentes como estos subrayan la importancia de las consideraciones éticas y legales en su desarrollo. Ya sea salvaguardando la privacidad, garantizando información precisa o evitando fallas relacionadas con datos confidenciales, empresas como OpenAI enfrentan la tarea de generar confianza mientras perfeccionan su tecnología. Estos desafíos nos recuerdan que incluso los sistemas de IA más avanzados requieren una vigilancia continua para abordar complejidades técnicas, éticas y legales.