Z.AI (anteriormente Zhipu) ha lanzado GLM-4.5, marcando la entrada de la compañía en el modelado de mezcla de experiencia abierta (MOE) con una serie diseñada específicamente para agentes autónomos de IA. El lanzamiento posiciona estos modelos como alternativas competitivas a las ofertas patentadas de OpenAI, Anthrope y Google.

Estrategia de lanzamiento de dos modelos

La familia GLM-4.5 incluye dos variantes optimizadas para diferentes requisitos computacionales:

1. GLM-4.5: El modelo insignia con 355 mil millones de parámetros totales y 32 mil millones de parámetros activos

2. GLM-4.5-AIR: una variante más eficiente con 106 mil millones de parámetros totales y 12 mil millones de parámetros activos

Se puede acceder a ambos modelos a través de múltiples canales, incluida la cara de abrazo [https://huggingface.co/collections/zai-org/glm-45-687c621d34bda8c9e4bf503b]OpenRouter [https://openrouter.ai/provider/z-ai]Plataforma de API Z.AI [http://docs.z.ai/guides/llm/glm-4.5]y chat de z.ai [http://chat.z.ai]garantizar un amplio acceso al desarrollador.

La arquitectura de MOE impulsa la eficiencia

Los modelos aprovechan la arquitectura de la mezcla de expertos para lograr una eficiencia computacional sustancial. En lugar de involucrar a todos los parámetros simultáneamente, el sistema enruta dinámicamente las tareas a componentes de red neuronales especializados. Este enfoque permite que GLM-4.5 active solo el 9% de sus parámetros totales (32B de 355b) durante la inferencia, mientras que el AIR GLM-4.5 opera con solo el 11% de activación (12b de 106b). La arquitectura ofrece un rendimiento comparable a modelos densos más grandes al tiempo que mantiene costos operativos similares a sistemas mucho más pequeños.

Imagen: https://www.globalnewslines.com/uploads/2025/08/b92d5127b8ebfb4c99dd8ace74735520.jpg

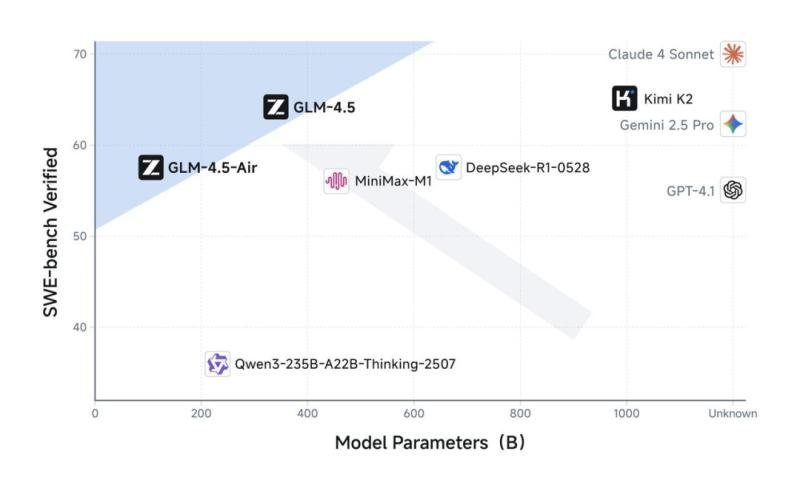

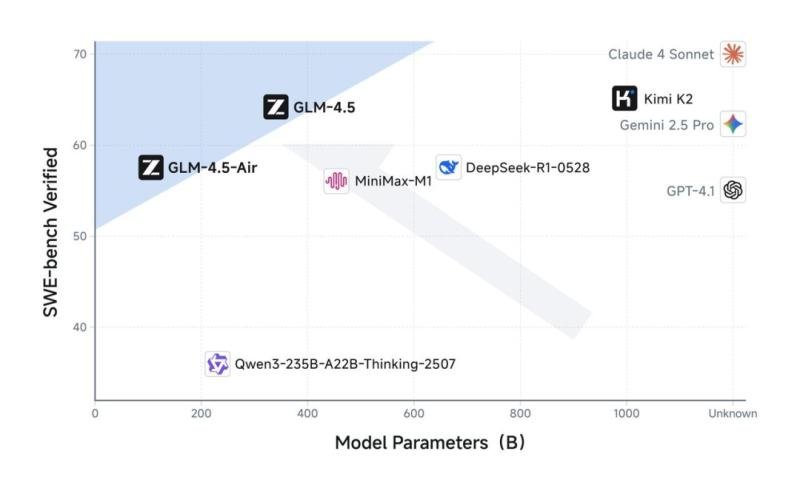

El mejor rendimiento en los puntos de referencia clave

Z.AI respaldó su lanzamiento con un conjunto de resultados de referencia que colocan GLM-4.5 entre los modelos de mejor rendimiento del mundo, ya que,, ya que de código cerrado y cerrado.

Imagen: https://www.globalnewslines.com/uploads/2025/08/918f015e1741dc8da09ed996c44160a9.jpg

Agente

GLM-4.5 demuestra un fuerte rendimiento en las tareas de agentes autónomos, que coinciden con el soneto Claude 4 en las evaluaciones Tau-Bench y BFCL V3. En particular, el modelo alcanzó el 26.4% en Browsecomp-A complejo de referencia de navegación web que supera el puntaje del 18.8% de Opus de Claude 4. La fiabilidad de la invocación de herramientas alcanzó el 90.6%, excediendo tanto a Claude (89.5%) como a Kimi-K2 (86.2%).

Razonamiento

El modelo muestra capacidades analíticas excepcionales con una precisión del 98.2% en los problemas de Math 500 y 91.0% en las tareas de competencia matemática AIME 2024. El rendimiento de los puntos de referencia de razonamiento general incluye 79.1% en GPQA y 84.6% en MMLU Pro, colocándolo entre los tres principales modelos a nivel mundial y primero entre las alternativas de código abierto.

Codificación

En las evaluaciones de programación, GLM-4.5 obtuvo un 64.2% en SWE-Bench verificado, superando a GPT-4.1 y acercándose a los resultados de Kimi-K2. El modelo alcanzó el 37.5% en el banco terminal, lo que demuestra competencia en entornos de línea de comandos y escenarios de programación de múltiples archivos.

Acceso abierto, listo para la empresa y asequible

Z.AI está haciendo un claro impulso para una adopción generalizada con su estrategia de licencias y precios. Ambos modelos se lanzan bajo la licencia Apache 2.0, lo que permite el uso comercial gratuito, la modificación y la redistribución de la máxima flexibilidad de los desarrolladores. Además, los modelos son accesibles a nivel mundial. Pueden ser autohospedados a través de la cara y la API global de Z.Ai, que es totalmente compatible con el punto final de la API de Claude, lo que hace que la integración sea perfecta.

En términos de precios, Z.AI está estableciendo un nuevo punto de referencia con tasas agresivamente bajas, con un máximo de $ 0.11 por millón de tokens de entrada y $ 0.28 por millón de tokens de salida, restringiendo significativamente a los principales competidores. Además, también ofrece un rendimiento de inferencia impresionante, alcanzando velocidades de más de 100 tokens por segundo en modo de alta velocidad y promediando 40-50 tokens por segundo en modo predeterminado, lo que lo hace listo para implementaciones de agente de grado a gran escala de producción.

Imagen: https://www.globalnewslines.com/uploads/2025/08/a301076efc9c3c7b1981434876a0efef.jpg

Imagen: https://www.globalnewslines.com/uploads/2025/08/a2ff08967871ae9256eb2c999c198463.jpg

Con esta combinación de rendimiento fuerte, integración amigable para los desarrolladores y acceso radicalmente asequible, el GLM-4.5 de Z.Ai está a punto de convertirse en un pilar fundamental para la próxima generación de desarrollo de IA.

La liberación de GLM-4.5 representa el posicionamiento estratégico de Z.AI en el panorama de IA en evolución, atacando a los desarrolladores y empresas que buscan un mayor control, transparencia y rentabilidad en comparación con las alternativas de código cerrado. El enfoque de código abierto proporciona opciones de audición y personalización al tiempo que ofrece un rendimiento competitivo con modelos propietarios.

Contacto con los medios

Nombre de la empresa: Z.Ai

Persona de contacto: Zixuan Li

Correo electrónico: Enviar correo electrónico [http://www.universalpressrelease.com/?pr=zai-launches-glm45-with-bold-opensource-push-chinas-top-llm-contender-challenges-big-tech]

País: Singapur

Sitio web: https://z.ai/chat

Descargo de responsabilidad legal: la información contenida en esta página es proporcionada por un proveedor de contenido de terceros independiente. GetNews no ofrece garantías, responsabilidad o responsabilidad por la precisión, contenido, imágenes, videos, licencias, integridad, legalidad o confiabilidad de la información contenida en este artículo. Si está afiliado a este artículo o tiene alguna queja o problemas de derechos de autor relacionados con este artículo y desea que se elimine, comuníquese con retract@swscontact.com

Este lanzamiento fue publicado en OpenPR.