Z.AI (anteriormente Zhipu) anunció hoy GLM-4.5V, un modelo de lenguaje de visión de código abierto diseñado para un razonamiento multimodal robusto a través de imágenes, video, documentos largos, gráficos y pantallas de GUI.

El razonamiento multimodal se ve ampliamente como un camino clave hacia AGI. GLM-4.5V avanza esa agenda con una arquitectura de clase de 100B (parámetros totales de 106b, 12b activo) que combina una alta precisión con un costo práctico de latencia e implementación. El lanzamiento sigue el pensamiento GLM-4.1V-9B de julio, que alcanzó el número 1 en abrazar la tendencia de la cara y ha superado las 130,000 descargas, y escamas que recetas a las cargas de trabajo empresariales mientras mantienen la ergonomía del desarrollador al frente y al centro. Se puede acceder al modelo a través de múltiples canales, incluido el abrazo de la cara. [http://huggingface.co/zai-org/GLM-4.5V]Github [http://github.com/zai-org/GLM-V]Plataforma de API Z.AI [http://docs.z.ai/guides/vlm/glm-4.5v]y chat de z.ai [http://chat.z.ai]garantizar un amplio acceso al desarrollador.

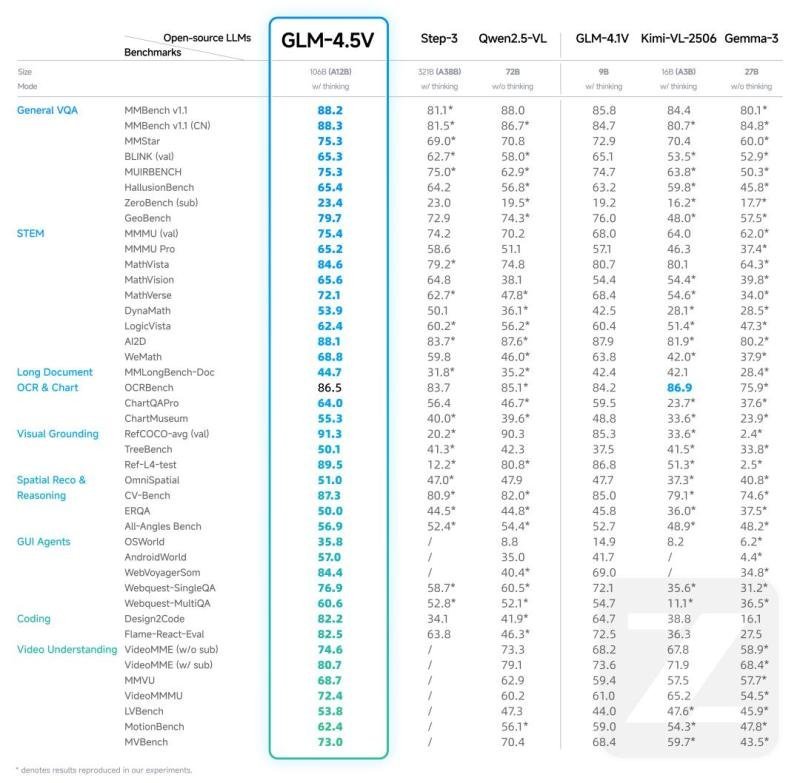

Sota de código abierto

Construido en la nueva base de texto GLM-4.5-Air y extendiendo el linaje de pensamiento GLM-4.1V, GLM-4.5V ofrece un rendimiento SOTA entre las VLM de código abierto de tamaño similar en 41 evaluaciones multimodales públicas. Más allá de las tablas de clasificación, el modelo está diseñado para la usabilidad y confiabilidad del mundo real en las entradas ruidosas, de alta resolución y de relación de aspecto extremo.

El resultado es el razonamiento visual de todos los escenarios en tuberías prácticas: razonamiento de imágenes (comprensión de la escena, análisis de múltiples imágenes, localización), comprensión de video (segmentación de tomas y reconocimiento de eventos), tareas de GUI (lectura de pantalla, detección de iconos, asistencia de escritorio), asistencia compleja y análisis de documentos complejos (comprensión de informes y extracción de información) y precisión precisa (localización de accesorios).

Imagen: https://www.globalnewslines.com/uploads/2025/08/1ca45a47819aaf6a111e702a896ee2bc.jpg

Capacidades clave

Grounding visual y localización

GLM-4.5V identifica y localiza con precisión los objetos objetivo basados en las indicaciones del idioma natural y devuelve las coordenadas limitadas. Esto permite aplicaciones de alto valor, como la inspección de seguridad y calidad o análisis de detección aérea/remota. En comparación con los detectores convencionales, el modelo aprovecha un conocimiento mundial más amplio y un razonamiento semántico más fuerte para seguir instrucciones de localización más complejas.

Los usuarios pueden cambiar al modo de posicionamiento visual, cargar una imagen y un aviso corto, y recuperar el cuadro y la justificación. Por ejemplo, pregunte “señale cualquier objeto no real en esta imagen”. GLM-4.5V razones sobre la plausibilidad y los materiales, luego marca el robot de rociadores similares a los insectos (el elemento resaltado en rojo en la demostración) como no real, devolviendo un cuadro limitado apretado un puntaje de confianza y una breve explicación.

Imagen: https://www.globalnewslines.com/uploads/2025/08/8dcbdd7939f12f7a2239bfbb0528b3f7.jpg

Diseño para código de capturas de pantalla y videos de interacción

El modelo analiza las capturas de pantalla de la página e incluso los videos de interacción para inferir jerarquía, reglas de diseño, estilos e intención, luego emite HTML/CSS/CSS/CSS fiel y ejecutable. Más allá de la detección de elementos, reconstruye la lógica subyacente y admite solicitudes de edición a nivel de región, lo que permite un bucle iterativo entre la entrada visual y el código listo para la producción.

Razonamiento de imagen del mundo abierto

GLM-4.5V puede inferir el contexto de fondo de señales visuales sutiles sin búsqueda externa. Dada un paisaje o una foto de la calle, puede razonar desde la vegetación, las huellas climáticas, la señalización y los estilos arquitectónicos para estimar la ubicación de tiro y las coordenadas aproximadas.

Por ejemplo, utilizando una escena clásica de Before Sunrise: “Basado en la arquitectura y las calles en el fondo, ¿puede identificar la ubicación específica en Viena, donde se filmó esta escena?” -El modelo analiza los detalles de los fachadas, los muebles de las calles y las señales de diseño para localizar el lugar exacto en Viena y las coordinadas de retorno y un nombre histórico. (Ver demostración: https://chat.z.ai/s/39233f25-8ce5-4488-9642-e07e7c638ef6).

Imagen: https://www.globalnewsslines.com/uploads/2025/08/f51fdc9fae815cfaf720bb07467a54db.jpg

Más allá de las imágenes individuales, el razonamiento del mundo abierto de GLM-5.5V escala en entornos competitivos: en un “juego geográfico” global, venció al 99% de los jugadores humanos en 16 horas y subió a clasificar 66 en siete días de evidencia clara de un rendimiento sólido del mundo real.

Documento complejo y comprensión del gráfico

El modelo lee documentos visualmente, páginas, figuras, tablas y gráficos que se encuentran con la confianza de depender de las tuberías de OCR quebradizas. Ese enfoque de extremo a extremo preserva la estructura y el diseño, mejorando la precisión para la resumen, la traducción, la extracción de información y los comentarios en informes largos y de medios mixtos.

Fundación de agentes de GUI

La comprensión de la pantalla incorporada permite a GLM-4.5V leer interfaces, localizar iconos y controles, y combinar el estado visual actual con instrucciones del usuario para planificar acciones. Emparejado con tiempos de ejecución del agente, admite la automatización de escritorio de extremo a extremo y las complejas tareas de agentes de GUI, proporcionando una columna vertebral visual confiable para los sistemas de agente.

Construido para razonamiento, diseñado para su uso

GLM-4.5V se basa en la nueva base de texto GLM-4.5-AIR y utiliza un moderno codificador de visión de tuberías VLM, adaptador MLP y decodificador LLM, con un contexto multimodal 64K, un contexto multimodal 64k, entradas de imagen y videos nativos, y un modelado espacial-temporal mejorado para que el sistema maneje el sistema de alta relación y contenido de ratio extrema con el estabilidad.

La pila de capacitación sigue una estrategia de tres etapas: pretrenesa multimodal a gran escala en datos de visión de texto intercalados y contextos largos; Autorización supervisada con formatos explícitos de la cadena de pensamiento para fortalecer el razonamiento causal y intermodal; y el aprendizaje de refuerzo que combina recompensas verificables con la retroalimentación humana para levantar los comportamientos STEM, la base y el agente. Un interruptor simple de pensamiento / no pensamiento permite la profundidad comercial de los constructores para la velocidad a pedido, alineando el modelo con variados objetivos de latencia de productos.

Imagen: https://www.globalnewslines.com/uploads/2025/08/8C8146F0727D80970ED4F09B16F3B316.JPG

Contacto con los medios

Nombre de la empresa: Z.Ai

Persona de contacto: Zixuan Li

Correo electrónico: Enviar correo electrónico [http://www.universalpressrelease.com/?pr=zai-launches-glm45v-opensource-visionlanguage-model-sets-new-bar-for-multimodal-reasoning]

País: Singapur

Sitio web: https://chat.z.ai/

Descargo de responsabilidad legal: la información contenida en esta página es proporcionada por un proveedor de contenido de terceros independiente. GetNews no ofrece garantías, responsabilidad o responsabilidad por la precisión, contenido, imágenes, videos, licencias, integridad, legalidad o confiabilidad de la información contenida en este artículo. Si está afiliado a este artículo o tiene alguna queja o problemas de derechos de autor relacionados con este artículo y desea que se elimine, comuníquese con retract@swscontact.com

Este lanzamiento fue publicado en OpenPR.